ACK 容器监控存储全面更新:让您的应用运行更稳定、更透明

背景

随着容器化应用的日益普及、业务规模的增长以及复杂度的增加,对容器化应用的存储性能和状况进行实时、精确的监控变得至关重要。阿里云容器服务 Kubernetes 版(ACK, Container Service for Kubernetes)的容器存储监控功能,正是为了解决这一问题,为用户提供更全面、更深入的存储资源洞察。ACK 在 Kubernetes 的基础上,为用户提供了多种容器数据卷类型,其中较为常用的数据卷包括:

1、本地存储:数据存放在 Pod 所在节点上的数据卷,例如 hostPath、emptyDir 等;

2、Secret 和 ConfigMap:两种特殊的数据卷,包含集群内部对象的信息;

3、PVC:一种定义集群外部数据卷的方式,能够将外部存储介质接入到集群中。在 ACK 集群中,我们较为推荐的三种阿里云云存储分别为云盘、NAS、OSS,它们覆盖的业务场景各不相同。通过 PVC 的方式将阿里云云存储接入到集群后,ACK 能够帮助用户更好地满足业务需求,拓宽业务场景。

其中,考虑到 Secret 和 ConfigMap 的特殊性,它们通常只会承担存储集群对象信息的作用,对存储可观测性的要求较低。因此,针对本地存储和 PVC 这两种容器存储使用方式,我们对 ACK 的容器存储监控功能进行了全新升级。此次更新完善了对集群中不同存储类型的监控能力,不仅对之前已有的监控大盘进行了优化,还针对不同的云存储类型,上线了全新的监控大盘,确保用户能够更好地理解和管理容器业务应用的存储资源。

新大盘优化思路

新存储监控大盘涵盖了 K8s 集群内部存储和外部存储两种存储形态。集群内部存储支持:

1、RootFS 监控:查看容器 RootFS 空间使用率和实时读写速率。

2、Pod 临时存储监控:查看临时存储空间使用率和 Inode 使用率。

集群外部存储支持:

1、云盘存储卷监控:查看云盘存储卷的概要信息(名称、命名空间、空间使用率等)、实时读写速率、读写延迟和读写吞吐量。

2、NAS 存储卷监控:查看 NAS 存储卷的概要信息(名称、命名空间、空间使用率等)、实时读写速率、读写延迟和读写吞吐量。

3、OSS 存储卷监控:查看 OSS 存储卷的概要信息(名称、命名空间、空间使用率等)、实时读写速率、读写吞吐量、OSS 操作每秒执行次数、POSIX 操作每秒执行次数和热点文件。

从具体改进形式上来说,本次更新上线了云盘、NAS、OSS 三块新的监控大盘,同时还在集群、节点、Pod 这三块已有监控大盘中添加了跟存储相关的监控图表。

新大盘内容展示

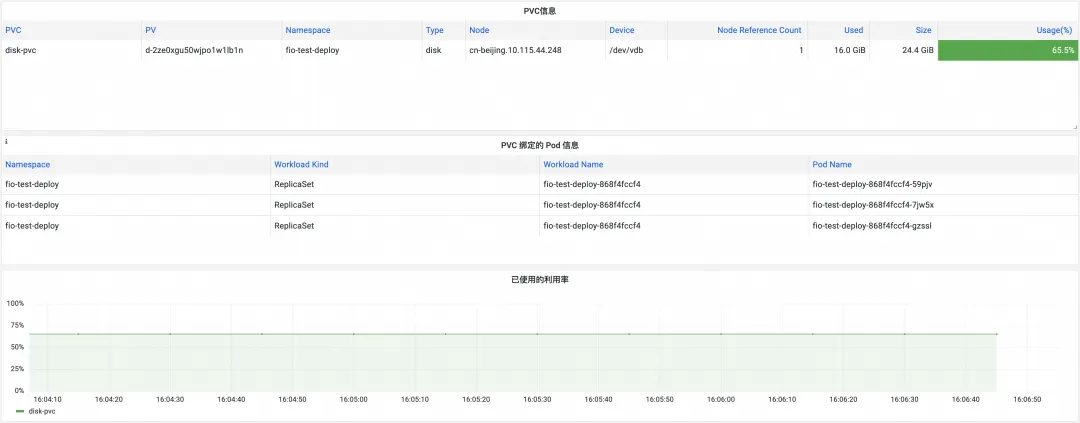

云盘存储卷监控

云盘存储卷的监控大盘界面如下:

其中,PVC 信息表格给出了所有云盘存储卷的信息,包括 PV 和 PVC 的名称、命名空间、所在节点、对应设备名称以及空间使用率等信息。PVC 绑定的 Pod 信息表格给出了 PVC 和工作负载的对应关系。大盘中的其他图表展示了云盘的空间使用量和实时读写数据。

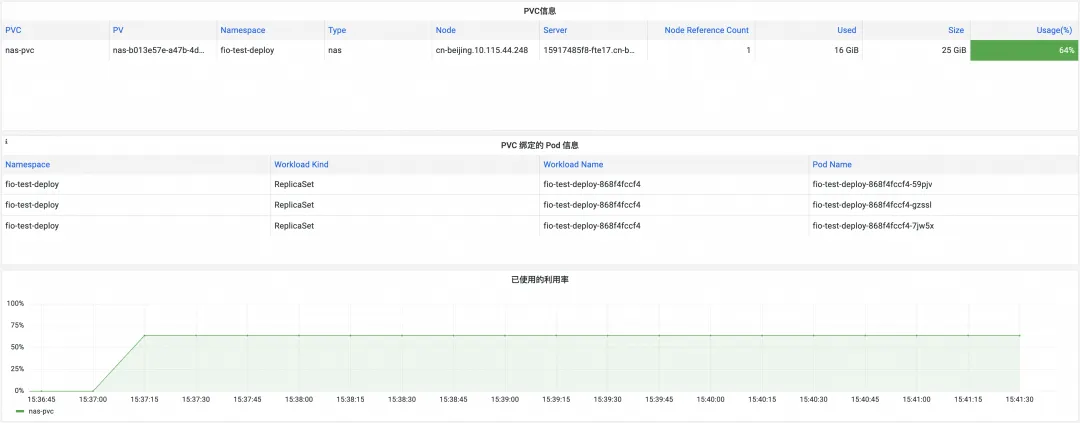

NAS 存储卷监控

NAS 存储卷的监控大盘界面如下:

NAS 监控大盘与云盘监控大盘的内容基本相同,唯一区别在于 PVC 信息表格中展示的是每个 NAS 存储卷的挂载点地址,而不是设备号。

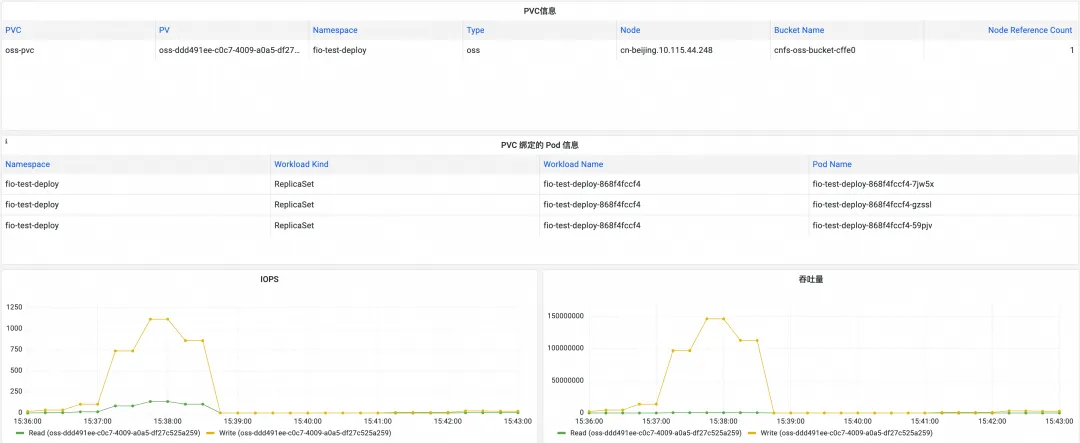

OSS 存储卷监控

OSS 存储卷的监控大盘界面如下:

其中,PVC 信息表格给出了每个 OSS 存储卷的 bucket 名称和其他基本信息。除了实时读写数据外,OSS 大盘还给出了各种 OSS 操作和 POSIX 操作每秒执行次数的统计数据,以及读写操作的热点路径统计数据。

集群监控

集群监控大盘新增了 PVC 概要信息表格,用户可以直观地查看集群中所有 PVC 的基本信息:

节点监控

节点监控大盘中新增了 PVC 概要信息和读写数据的展示:

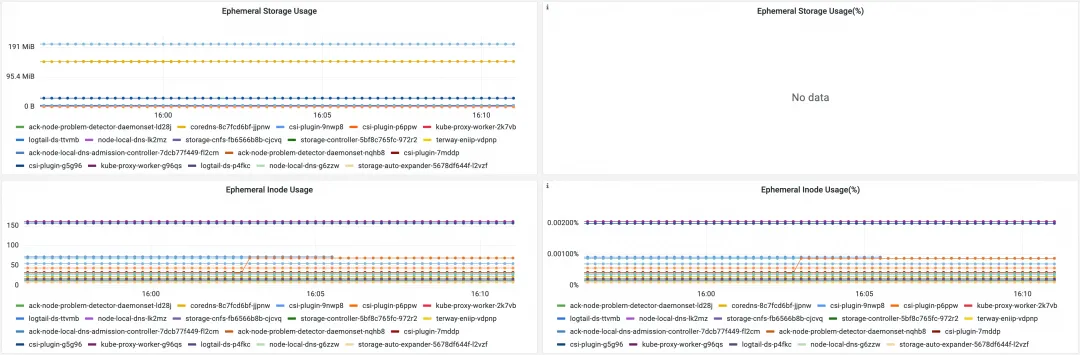

Pod 监控

Pod 监控大盘中新增了 RootFS 和 Ephemeral Storage 的监控数据,其中 RootFS 相关指标展示了 Pod 中所有容器的 RootFS 相关信息,如可用存储空间总量、读写总数据量等。而 Ephemeral Storage 相关指标则涵盖了以下三个部分的相关信息:

1、除 tmpfs 类型的 emptyDir 外,Pod 挂载的其他类型 emptyDir

2、节点上存储 Pod 日志的文件

3、Pod 中所有容器的可写层

增强的 Ephemeral Storage 监控能力

注意大盘中的 Ephemeral Storage Usage(%) 图表只会显示所有配置了 resources.limits.ephemeral-storage 的容器的信息。

另外值得注意的是,RootFS 相关指标由 cAdvisor 组件透出,而当容器运行时为 containerd 时,cAdvisor 不会提供 Pod 维度的监控指标。虽然社区曾经尝试对这个问题进行了修复[1],但由于代码实现带来的二方依赖打破了 K8s 的单向依赖原则,该修复最终被回退[2]。考虑到 containerd 为 ACK 集群 1.24 及以上版本的默认容器运行时,我们在 ACK csi-plugin 组件中对该问题进行了修复,用户只需安装 v1.28.3-eb95171-aliyun 及以上版本的 csi-plugin 组件就可以解决 Pod 维度的 Ephemeral Storage 监控数据缺失的问题。

总结

容器存储是容器应用运行时的数据保障,本次 ACK 容器存储监控的更新能够帮助用户全面、精细地掌控集群中的存储细节,快速定位业务运行过程中可能出现的 IO 瓶颈和 IO 问题,更好地保证业务的平稳运行。

参考文章:

Resource Management for Pods and Containers

Monitoring cAdvisor with Prometheus

相关链接:

[1] 修复

[2] 回退